เริ่มเร็วสุดขีด ตัดความซับซ้อน

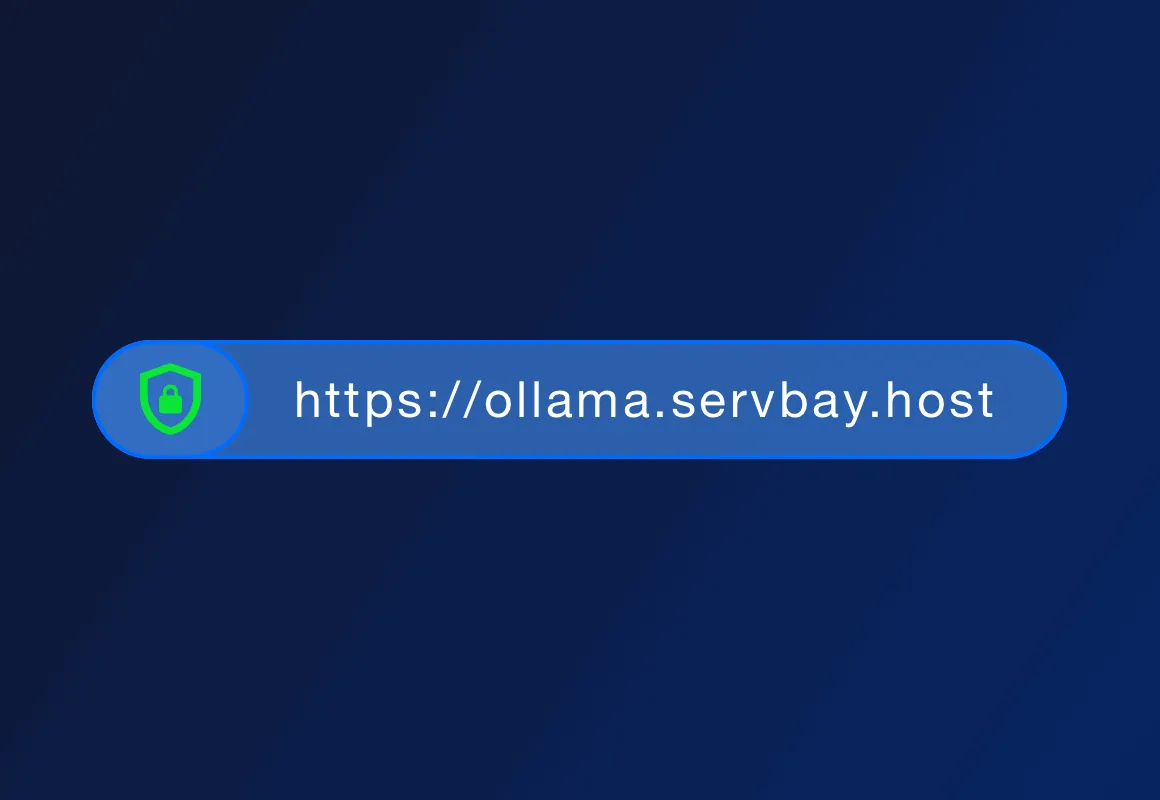

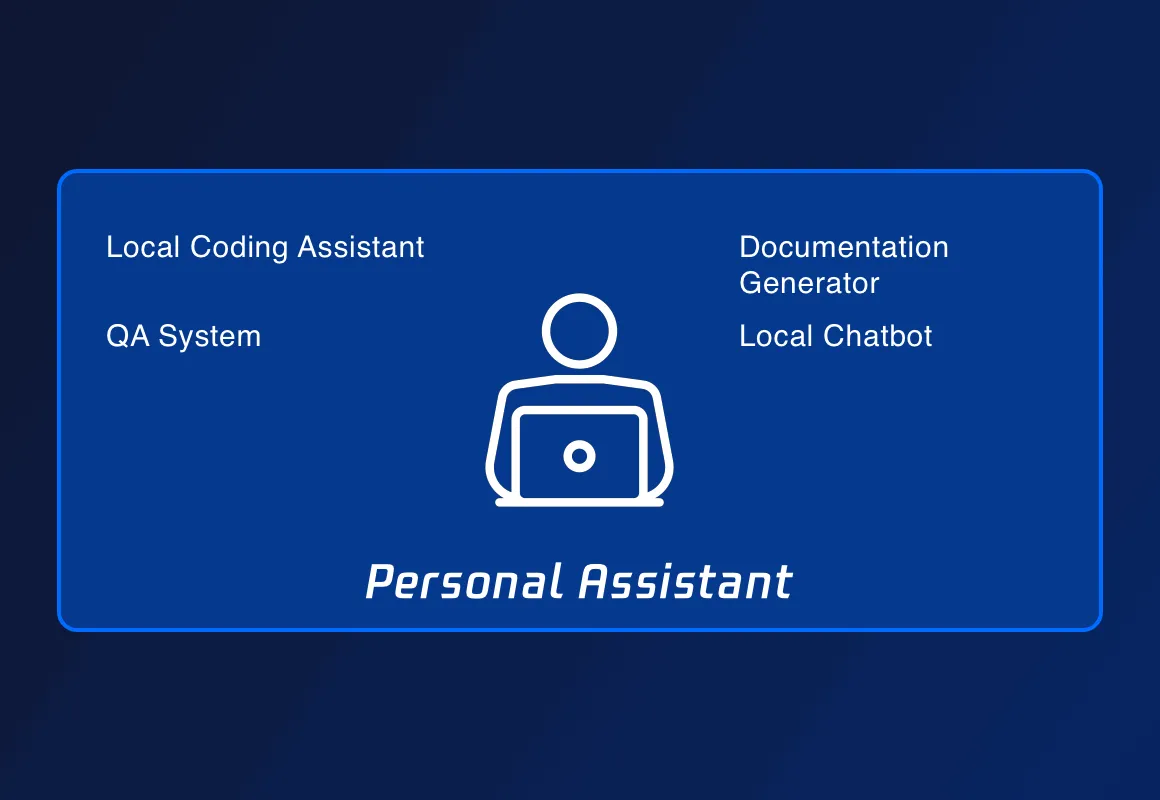

จุดแข็งหลักของ ServBay คือ ติดตั้ง AI ในเครื่องเดียว/ควบคุมข้อมูลส่วนตัว ใช้งาน offline ได้ ไม่ต้องกลัวข้อมูลรั่วหรือพึ่ง cloud

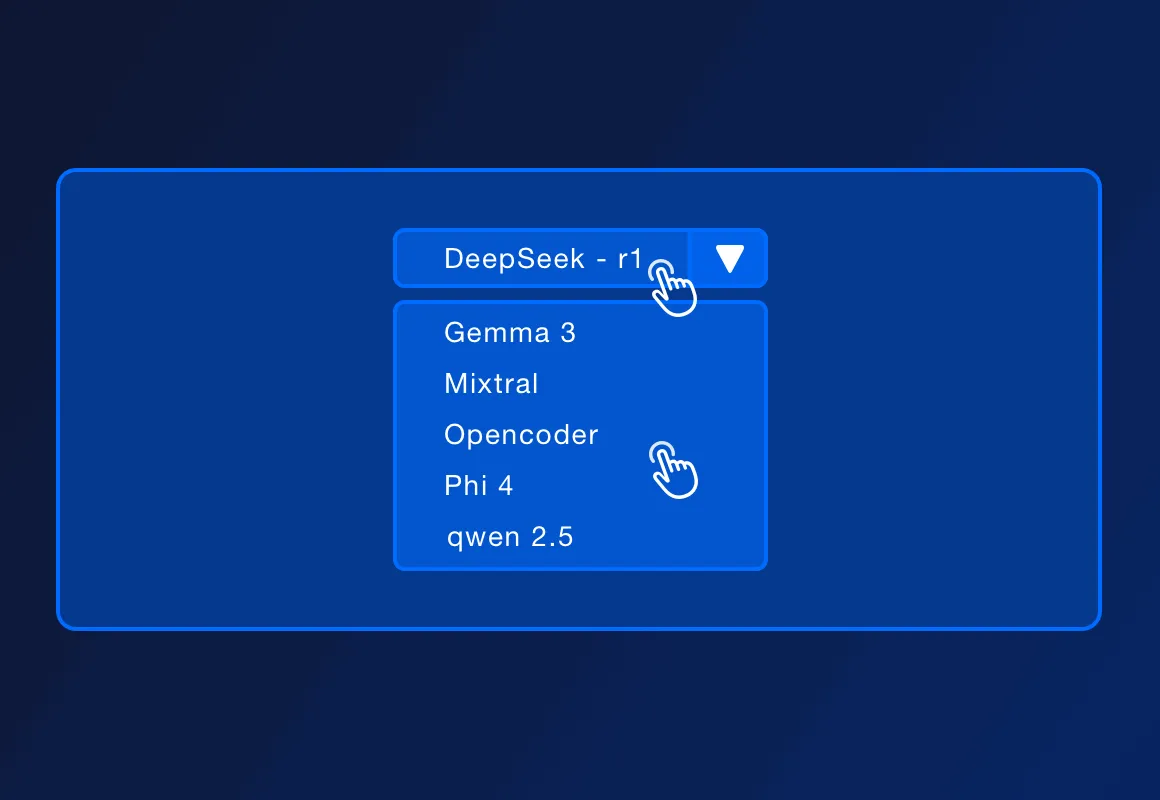

รองรับ DeepSeek - r1, Llama 3.3, Mistral, Code Llama และอื่นๆ อัปเดตใหม่ต่อเนื่อง

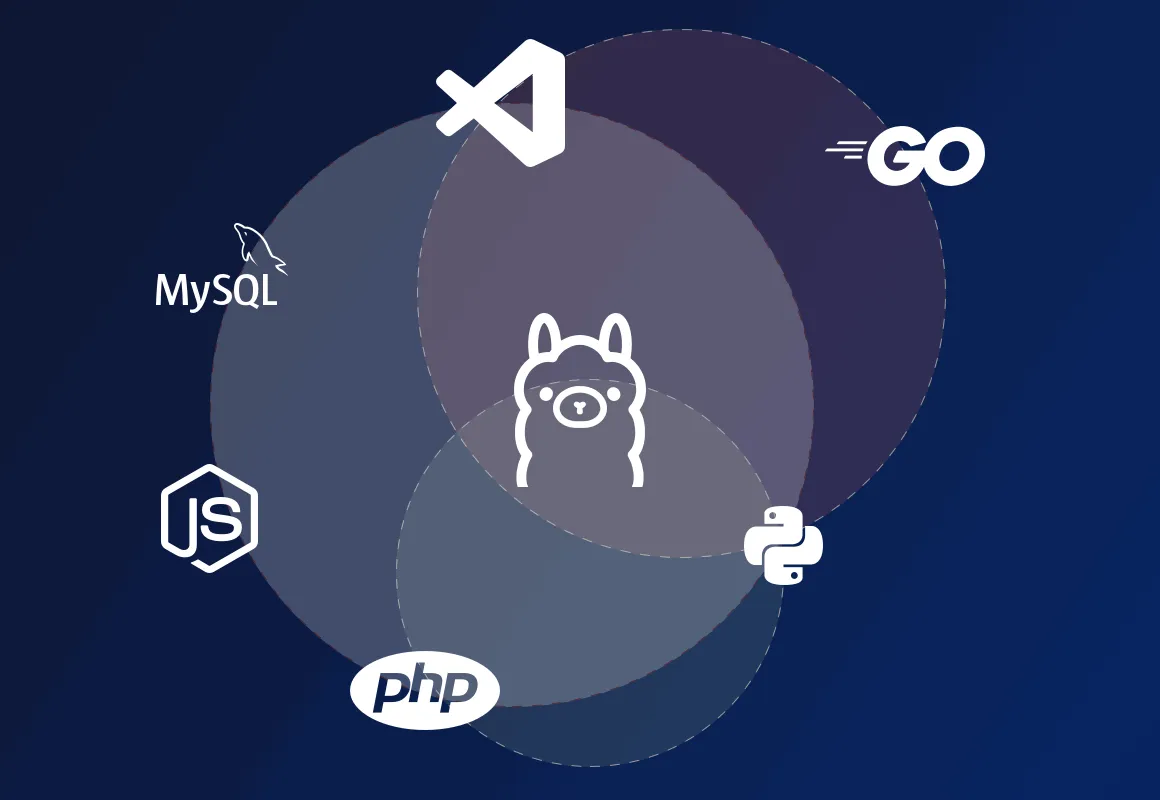

สามารถใช้ local dev หรือเรียนรู้/prototype ได้ Deploy ใน macOS พร้อม PHP/Python/Node.js/Go ธุรกิจที่ต้อง high concurrency/high reliability มีทางเลือกรองรับ

ServBay คือ management platform สำหรับ dev ทุกรูปแบบ รองรับภาษาและระบบต่างๆ ปุ่มสั่งงาน ใช้ API ของ Ollama ทดสอบ AI แบบ local ได้ทุกแพลตฟอร์ม