Super Pantas, Tiada Lagi Leceh

Utama: satu klik pemasangan, running tempatan, privasi data, offline. Berbanding cloud, tiada keperluan rangkaian, data tidak bocor.

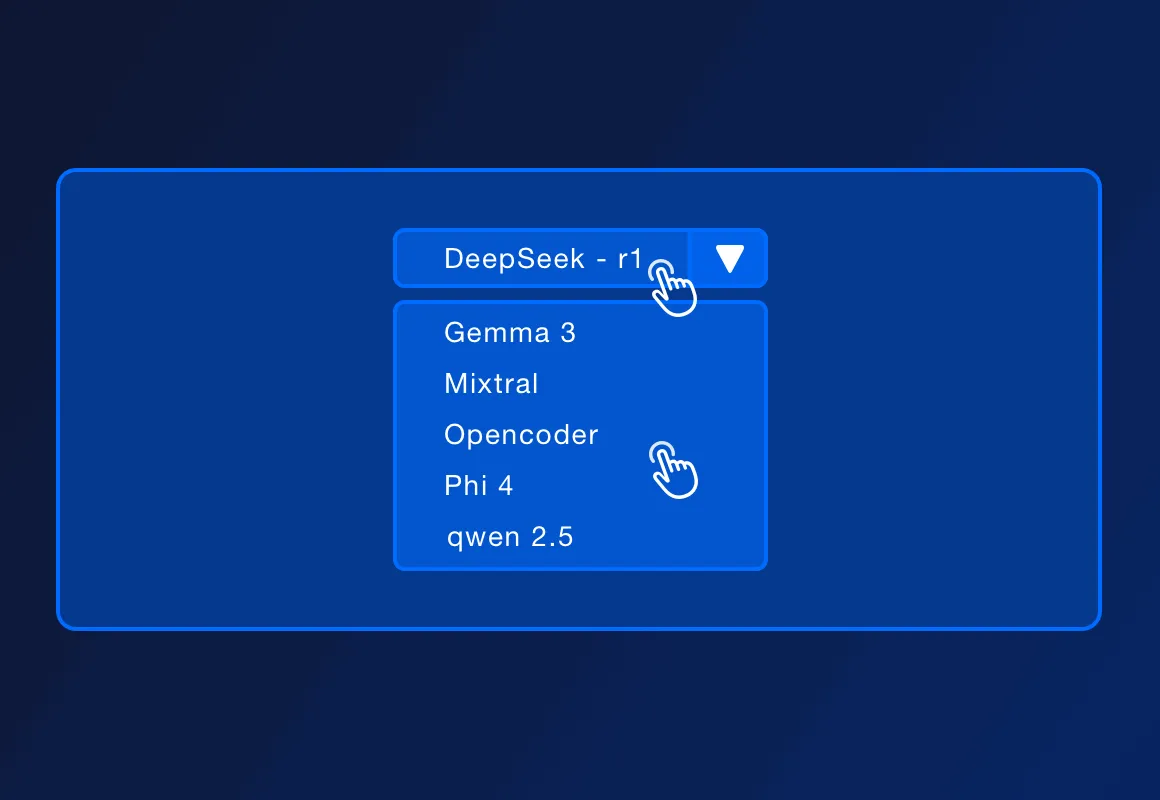

Pelbagai LLM open-source popular: DeepSeek-r1, Llama 3.3, Mistral, Code Llama dsb. Senarai akan sentiasa dikemas kini.

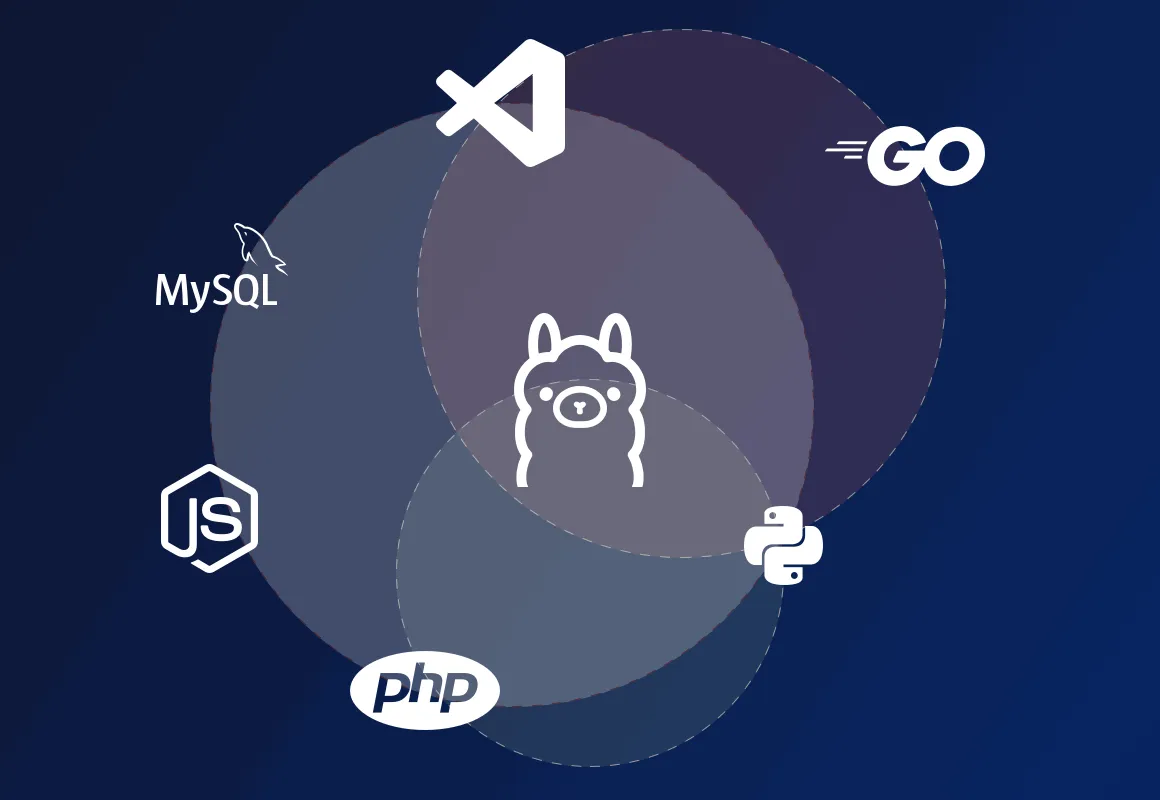

ServBay boleh deploy PHP, Python, Node.js, Go dll dan Ollama dalam lokal — sesuai untuk development, prototaip, pembelajaran & penggunaan individu. Untuk high-availability, ada solusi enterprise.

ServBay ialah platform pengurusan environment pembangunan untuk PHP, Python, Node.js, Go, database dan server. Kini, pemasangan Ollama satu klik — gunakan REST API Ollama untuk bina AI-driven apps lokal.